A medida que se desarrollan los meses de 2024, todos somos parte de un año extraordinario para la historia de la democracia y la tecnología. Más países y personas votarán por sus líderes electos que en cualquier otro año en la historia humana. Al mismo tiempo, el desarrollo de la IA avanza cada vez más rápido, para ofrecer beneficios extraordinarios pero también para permitir a los actores malintencionados engañar a los votantes con la creación de «deepfakes» realistas de candidatos y otras personas. El contraste entre la promesa y el peligro de la nueva tecnología rara vez ha sido más impactante.

De manera rápida, este se ha convertido en un año que requiere que todos nosotros, que nos preocupamos por la democracia, trabajemos juntos para enfrentar el momento.

Hace unos días, el sector tecnológico se unió en la Conferencia de Seguridad de Múnich para dar un paso vital hacia adelante. Juntas, 20 empresas1 anunciaron un nuevo Acuerdo Tecnológico para Combatir el Uso Engañoso de la IA en las Elecciones de 2024. Su objetivo es sencillo pero crítico: combatir los videos, audios e imágenes que falsifican o alteran la apariencia, la voz o las acciones de los candidatos políticos, funcionarios electorales y otros actores clave. No es una iniciativa partidista ni está diseñada para desalentar la libre expresión. Su objetivo es garantizar que los votantes conserven el derecho a elegir quién los gobierna, libres de este nuevo tipo de manipulación basada en IA.

Los desafíos son formidables y nuestras expectativas deben ser realistas. Pero el acuerdo representa un paso raro y decisivo, unificar el sector tecnológico con compromisos voluntarios concretos en un momento vital para ayudar a proteger las elecciones que se llevarán a cabo en más de 65 naciones entre principios de marzo y finales de año.

Si bien se necesitarán muchos más pasos, hoy marca el lanzamiento de una iniciativa en verdad global para tomar medidas prácticas inmediatas y generar más y un mayor impulso.

¿Cuál es el problema que tratamos de resolver?

Vale la pena comenzar con el problema que necesitamos resolver. Las nuevas herramientas generativas de IA hacen posible crear audio, video e imágenes realistas y convincentes que falsifican o alteran la apariencia, la voz o las acciones de las personas. A menudo se les llama «deepfakes«. Los costos de creación son bajos y los resultados son impresionantes. El Laboratorio de AI for Good de Microsoft me demostró esto por primera vez el año pasado cuando tomaron productos de uso común, gastaron menos de $20 en tiempo de cómputo y crearon videos realistas que no solo pusieron nuevas palabras en mi boca, sino que me hicieron usarlas en discursos en español y mandarín que coincidían con el sonido de mi voz y el movimiento de mis labios.

En realidad, lucho con el francés y a veces tropiezo incluso en inglés. No puedo hablar más que unas pocas palabras en cualquier otro idioma. Pero, para alguien que no me conoce, los videos parecían genuinos.

La IA trae una nueva y potencialmente más peligrosa forma de manipulación que hemos buscado abordar durante más de una década, desde sitios web falsos hasta bots en las redes sociales. En los últimos meses, el público en general ha presenciado con rapidez este problema en expansión y los riesgos que esto crea para nuestras elecciones. Antes de las primarias de New Hampshire, los votantes recibieron llamadas automáticas que usaban IA para falsificar la voz y las palabras del presidente Biden. Esto siguió a la publicación documentada de varios videos deepfake a partir de diciembre del primer ministro del Reino Unido, Rishi Sunak. Estos son similares a los videos deepfake que el Centro de Análisis de Amenazas de Microsoft (MTAC, por sus siglas en inglés) ha rastreado hasta actores patrocinados por el estado, incluido un esfuerzo patrocinado por el estado ruso para insertar segmentos de audio falsos en extractos de videos de noticias genuinos.

Todo esto se suma a un creciente riesgo de que los actores malintencionados utilicen IA y deepfakes para engañar al público en una elección. Y esto va a una piedra angular de todas las sociedades democráticas del mundo: la capacidad de un público informado con precisión para elegir a los líderes que los gobernarán.

Este desafío de deepfake conecta dos partes del sector tecnológico. La primera son las empresas que crean modelos, aplicaciones y servicios de IA que se pueden usar para crear contenido de video, audio e imagen realista. Y la segunda son las empresas que ejecutan servicios de consumo donde los individuos pueden distribuir deepfakes al público. Microsoft trabaja en ambos espacios. Desarrollamos y alojamos modelos y servicios de IA en Azure en nuestros centros de datos, creamos tecnología de voz sintética, ofrecemos herramientas de creación de imágenes en Copilot y Bing, y proporcionamos aplicaciones como Microsoft Designer, que es una aplicación de diseño gráfico que permite a las personas crear imágenes de alta calidad con facilidad. Y operamos servicios de consumo alojados, incluido LinkedIn y nuestra red de juegos, entre otros.

Esto nos ha dado visibilidad a toda la gama de la evolución del problema y el potencial de nuevas soluciones. A medida que hemos visto crecer el problema, los científicos de datos e ingenieros de nuestro Laboratorio de AI for Good y los analistas de MTAC han dirigido más su enfoque, incluso con el uso de IA, en la identificación de deepfakes, el seguimiento de actores malintencionados y el análisis de sus tácticas, técnicas y procedimientos. En algunos aspectos, hemos visto prácticas que hemos combatido durante mucho tiempo en otros contextos a través del trabajo de nuestra Unidad de Delitos Digitales, incluidas actividades que llegan a la web oscura. Si bien el desafío de deepfake será difícil de derrotar, esto nos ha convencido de que tenemos muchas herramientas que podemos poner a trabajar de manera rápida.

Como muchos otros problemas tecnológicos, nuestro desafío más básico no es técnico sino totalmente humano. A medida que los meses de 2023 llegaban a su fin, los deepfakes se habían convertido en un tema creciente de conversación en las capitales de todo el mundo. Pero mientras todos parecían estar de acuerdo en que se necesitaba hacer algo, muy pocas personas hacían lo suficiente, en especial de manera colaborativa. Y con las elecciones a la vista, parecía que el tiempo se agotaba. Esa necesidad de un nuevo sentido de urgencia, tanto como cualquier otra cosa, impulsó el trabajo colaborativo que ha llevado al acuerdo lanzado hoy en Múnich.

¿Qué anunció el sector tecnológico y marcará la diferencia?

Creo que este es un día importante, que culmina el arduo trabajo de buenas personas en muchas empresas en todo el sector tecnológico. El nuevo acuerdo reúne a empresas de ambas partes relevantes de nuestra industria: aquellas que crean servicios de IA que se pueden usar para crear deepfakes y aquellas que ejecutan servicios de consumo alojados donde se pueden difundir deepfakes. Si bien el desafío es formidable, este es un paso vital que ayudará a proteger mejor las elecciones que se llevarán a cabo este año.

Es útil repasar lo que hace este acuerdo y cómo nos moveremos de inmediato para implementarlo como Microsoft.

El acuerdo se centra de manera explícita en un conjunto definido en concreto de abusos de deepfake. Se dirige al «Contenido engañoso de IA en las elecciones», que se define como «audio, video e imágenes generados por IA convincentes que falsifican o alteran de manera engañosa la apariencia, la voz o las acciones de los candidatos políticos, funcionarios electorales y otros actores clave en una elección democrática, o que proporcionan información falsa a los votantes sobre cuándo, dónde y cómo pueden votar de manera legal».

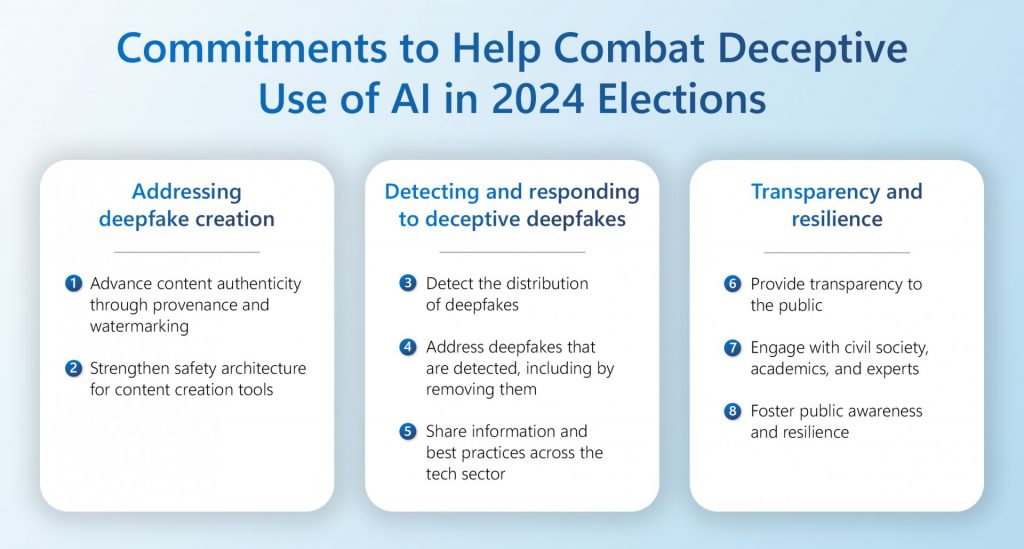

El acuerdo aborda este abuso de contenido a través de ocho compromisos específicos, y todos valen la pena leer. Para mí, caen en tres categorías críticas que vale la pena pensar más:

Primero, los compromisos del acuerdo dificultarán que los actores malintencionados utilicen herramientas legítimas para crear deepfakes. Los dos primeros compromisos del acuerdo avanzan hacia este objetivo. En parte, esto se centra en el trabajo de las empresas que crean herramientas de generación de contenido y les pide que fortalezcan la arquitectura de seguridad en los servicios de IA mediante la evaluación de riesgos y el fortalecimiento de los controles para ayudar a prevenir el abuso. Esto incluye aspectos como el análisis continuo del equipo rojo, los clasificadores preventivos, el bloqueo de indicaciones abusivas, las pruebas automatizadas y las prohibiciones rápidas de los usuarios que abusan del sistema. Todo esto necesita basarse en un análisis de datos sólido y de amplia base. Piensen en esto como seguridad por diseño.

Esto también se centra en la autenticidad del contenido al avanzar lo que el sector tecnológico se refiere como procedencia del contenido y marca de agua. Los productos de diseño de video, audio e imagen pueden incorporar características de procedencia de contenido que adjuntan metadatos o incrustan señales en el contenido que producen con información sobre quién lo creó, cuándo se creó y el producto que se utilizó, incluida la participación de la IA. Esto puede ayudar a las organizaciones de medios e incluso a los consumidores a separar mejor el contenido auténtico del inauténtico. Y la buena noticia es que la industria se mueve con rapidez para unirse en torno a un enfoque común, el estándar C2PA, para ayudar a avanzar en esto.

Pero la procedencia no es suficiente por sí sola, porque los actores malintencionados pueden usar otras herramientas para eliminar esta información del contenido. Como resultado, es importante agregar otros métodos como la incrustación de una marca de agua invisible junto con los metadatos firmados por C2PA y explorar formas de detectar contenido incluso después de que estas señales se eliminen o se degraden, como al marcar una imagen con un hash único que podría permitir a las personas hacer coincidir con un registro de procedencia en una base de datos segura.

El acuerdo de hace unos días ayuda a mover al sector tecnológico más lejos y más rápido en comprometerse, innovar y adoptar estos enfoques tecnológicos. Se basa en los compromisos voluntarios de la Casa Blanca que varias empresas en los Estados Unidos adoptaron por primera vez en julio pasado y en el enfoque de la Ley de Servicios Digitales de la Unión Europea sobre la integridad de los procesos electorales. En Microsoft, trabajamos para acelerar nuestro trabajo en estas áreas en todos nuestros productos y servicios. Y el próximo mes lanzaremos nuevas Credenciales de Contenido como Servicio para ayudar a apoyar a los candidatos políticos en todo el mundo, respaldados por un equipo dedicado de Microsoft.

Me anima el hecho de que, en muchos aspectos, todas estas nuevas tecnologías representan el último capítulo del trabajo que hemos perseguido en Microsoft durante más de 25 años. Cuando los CD-ROM y luego los DVD se hicieron populares a principios de la década de 1990, los falsificadores intentaron engañar al público y defraudar a los consumidores al crear versiones falsas de aspecto realista de productos populares de Microsoft.

Respondimos con una serie de características cada vez más sofisticadas contra la falsificación, incluida la marca de agua física invisible, que son los precursores de la protección digital que avanzamos hoy. Nuestra Unidad de Delitos Digitales desarrolló enfoques que la colocaron a la vanguardia mundial en el uso de estas características para protegerse contra una generación de falsificaciones tecnológicas. Si bien siempre es imposible erradicar por completo cualquier forma de delito, podemos volver a llamar a estos equipos y a este espíritu de determinación y colaboración para poner los avances de hoy en uso efectivo.

En segundo lugar, el acuerdo une al sector tecnológico para detectar y responder a deepfakes en las elecciones. Esta es una segunda categoría esencial, porque la dura realidad es que los actores malintencionados decididos, quizás en especial los estados-nación bien dotados de recursos, invertirán en sus propias innovaciones y herramientas para crear deepfakes y usarlos para intentar interrumpir las elecciones. Como resultado, debemos suponer que necesitaremos invertir en acción colectiva para detectar y responder a esta actividad.

Los tercer y cuarto compromisos en el acuerdo avanzarán en las capacidades de detección y respuesta de la industria. En Microsoft, nos movemos de inmediato en ambas áreas. En el frente de detección, aprovechamos las capacidades de ciencia de datos y técnicas de nuestro Laboratorio de AI for Good y el equipo de MTAC para detectar mejor los deepfakes en Internet. Llamaremos a la experiencia de nuestra Unidad de Delitos Digitales para invertir en un nuevo trabajo de inteligencia de amenazas para perseguir la detección temprana de la actividad delictiva impulsada por la IA.

También lanzamos de inmediato una nueva página web, Microsoft-2024 Elections, donde un candidato político puede informarnos sobre una preocupación acerca de un deepfake de sí mismo. En esencia, esto empodera a los candidatos políticos de todo el mundo para ayudar con la detección global de deepfakes.

Combinamos este trabajo con el lanzamiento de una Unidad de Seguridad Digital ampliada. Esto extenderá el trabajo de nuestro equipo de seguridad digital existente, que durante mucho tiempo ha abordado el contenido y la conducta en línea abusivos que afectan a los niños o que promueven la violencia extremista, entre otras categorías. Este equipo tiene una habilidad especial para responder las 24 horas del día, los 7 días de la semana, al contenido armamentístico de los tiroteos masivos sobre los que actuamos de inmediato para eliminarlo de nuestros servicios.

Estamos comprometidos a fondo con la importancia de la libre expresión, pero no creemos que esto deba proteger los deepfakes u otro contenido electoral de IA engañoso cubierto por el acuerdo de hoy. Por lo tanto, actuaremos con rapidez para eliminar y prohibir este tipo de contenido de LinkedIn, nuestra red de juegos y otros servicios relevantes de Microsoft de acuerdo con nuestras políticas y prácticas. Al mismo tiempo, publicaremos de manera rápida una política que aclare nuestros estándares y enfoque, y crearemos un proceso de apelación que se moverá con velocidad si un usuario cree que su contenido fue eliminado por error.

Igual de importante, como se aborda en el quinto compromiso del acuerdo, estamos dedicados a compartir con el resto del sector tecnológico y las ONG apropiadas la información sobre los deepfakes que detectamos y las mejores prácticas y herramientas que ayudamos a desarrollar. Estamos comprometidos a avanzar en una acción colectiva más fuerte, que ha demostrado ser indispensable para proteger a los niños y abordar la violencia extremista en Internet. Respetamos y apreciamos el trabajo que otras empresas tecnológicas y ONG han avanzado durante mucho tiempo en estas áreas, incluido a través del Foro Global de Internet para Contrarrestar el Terrorismo, o GIFCT (por sus siglas en inglés), y con gobiernos y la sociedad civil bajo el Llamado de Christchurch.

En tercer lugar, el acuerdo ayudará a avanzar en la transparencia y a construir resiliencia social a los deepfakes en las elecciones. Los tres compromisos finales en el acuerdo abordan la necesidad de transparencia y la amplia resiliencia que debemos fomentar en las democracias del mundo.

Como se refleja en el sexto compromiso del acuerdo, apoyamos la necesidad de transparencia pública sobre nuestro trabajo corporativo y colectivo más amplio. Este compromiso con la transparencia será parte del enfoque que adopta nuestra Unidad de Seguridad Digital al abordar los deepfakes de los candidatos políticos y las otras categorías cubiertas por el acuerdo de hoy. Esto también incluirá el desarrollo de un nuevo informe de transparencia anual que publicaremos que cubre nuestras políticas y datos sobre cómo las aplicamos.

El séptimo compromiso del acuerdo obliga al sector tecnológico a seguir con la interacción con un conjunto diverso de organizaciones de la sociedad civil global, académicos y otros expertos en la materia. Estos grupos e individuos desempeñan un papel indispensable en la promoción y protección de las democracias del mundo. Durante más de dos siglos, han sido fundamentales para el avance de los derechos y principios democráticos, incluido su trabajo crítico para avanzar en la abolición de la esclavitud y la expansión del derecho al voto en los Estados Unidos.

Como empresa, esperamos seguir la interacción con estos grupos. Cuando grupos diversos se unen, no siempre comenzamos con la misma perspectiva, y hay días en que las conversaciones pueden ser desafiantes. Pero apreciamos por experiencia de larga data que uno de los sellos distintivos de la democracia es que las personas no siempre están de acuerdo entre sí. Sin embargo, cuando las personas en verdad escuchan puntos de vista diferentes, casi siempre aprenden algo nuevo. Y de este aprendizaje surge una base para mejores ideas y un mayor progreso. Quizás más que nunca, los problemas que conectan la democracia y la tecnología requieren una amplia carpa con espacio para escuchar muchas ideas diferentes.

Esto también proporciona una base para el compromiso final del acuerdo, que es el apoyo al trabajo para fomentar la conciencia pública y la resiliencia con respecto al contenido engañoso de IA en las elecciones. Como hemos aprendido de primera mano en elecciones recientes en lugares tan distantes entre sí como Finlandia y Taiwán, un público astuto e informado puede proporcionar la mejor defensa de todas al riesgo de deepfakes en las elecciones. Uno de nuestros objetivos generales de procedencia de contenido es equipar a las personas con la capacidad de buscar con facilidad indicadores de C2PA que denotarán si el contenido es auténtico. Pero esto requerirá esfuerzos de concienciación pública para ayudar a las personas a aprender dónde y cómo buscar esto.

Actuaremos con rapidez para implementar este compromiso final, incluida la asociación con otras empresas de tecnología y el apoyo a organizaciones de la sociedad civil para ayudar a equipar al público con la información necesaria. Estén atentos a nuevos pasos y anuncios en las próximas semanas.

¿El acuerdo tecnológico hace todo lo que necesita hacerse?

Esta es la pregunta final que todos deberíamos hacernos al considerar el importante paso dado hoy. Y, a pesar de mi enorme entusiasmo, sería el primero en decir que este acuerdo representa solo uno de los muchos pasos vitales que tendremos que dar para proteger las elecciones.

En parte, esto se debe a que el desafío es formidable. La iniciativa requiere nuevos pasos de una amplia gama de empresas. Es probable que los actores malintencionados también se innoven a sí mismos, y la tecnología subyacente cambia con rapidez. Necesitamos ser muy ambiciosos pero también realistas. Tendremos que seguir con el aprendizaje, la innovación y adaptándonos. Como empresa e industria, Microsoft y el sector tecnológico tendrán que basarse en el paso de hoy y seguir con las inversiones en mejorar.

Pero aún más importante, no hay forma de que el sector tecnológico pueda proteger las elecciones por sí solo de este nuevo tipo de abuso electoral. Y, aunque pudiera, no sería adecuado. Después de todo, hablamos de la elección de líderes en una democracia. Y nadie eligió a ningún ejecutivo o empresa tecnológica para liderar ningún país.

Una vez que uno reflexiona por un momento sobre esta proposición más básica, queda bastante claro que la protección de las elecciones requiere que todos trabajemos juntos.

En muchos sentidos, esto comienza con nuestros líderes elegidos y las instituciones democráticas que lideran. La protección definitiva de cualquier sociedad democrática es el estado de derecho en sí mismo. Y, como hemos señalado en otro lugar, es fundamental que implementemos las leyes existentes y apoyemos el desarrollo de nuevas leyes para abordar este problema en evolución. Esto significa que el mundo necesitará nuevas iniciativas de líderes elegidos para avanzar en estas medidas.

Entre otras áreas, esto será esencial para abordar el uso de deepfakes de IA por parte de estados nación bien dotados de recursos. Como hemos visto en los paisajes de ciberseguridad e influencia cibernética, un pequeño número de gobiernos sofisticados han comenzado a poner recursos y experiencia sustanciales en nuevos tipos de ataques a individuos, organizaciones e incluso países. Se podría argumentar que, en algunos días, el ciberespacio es el espacio donde el estado de derecho está más amenazado. Y necesitaremos más liderazgo intergubernamental colectivo para abordar esto.

Al mirar hacia el futuro, parece para aquellos de nosotros que trabajamos en Microsoft que también necesitaremos nuevas formas de acción de múltiples partes interesadas. Creemos que iniciativas como el Llamado de París y el Llamado de Christchurch han tenido un impacto positivo en el mundo justo porque han reunido a personas de gobiernos, el sector tecnológico y la sociedad civil para trabajar en una base internacional. Al abordar no solo los deepfakes sino casi todos los demás problemas tecnológicos en el mundo hoy, nos resulta difícil creer que cualquier parte de la sociedad pueda resolver un gran problema si actúa sola.

Por eso es tan importante que el acuerdo de hoy reconozca de manera explícita que «la protección de la integridad electoral y la confianza pública es una responsabilidad compartida y un bien común que trasciende los intereses partidistas y las fronteras nacionales».

Quizás más que nada, esto necesita ser nuestra estrella guía.

Solo al trabajar juntos podemos preservar valores atemporales y principios democráticos en un momento de enorme cambio tecnológico.